Η συνάρτηση pipeline() είναι αναπόσπαστο μέρος της βιβλιοθήκης Transformer. Χρειάζονται πολλές εισόδους στις οποίες μπορούμε να ορίσουμε μια εργασία συμπερασμάτων, μοντέλα, μηχανισμό tokenization, κ.λπ. Μια συνάρτηση pipeline() χρησιμοποιείται κυρίως για την εκτέλεση εργασιών NLP σε ένα ή περισσότερα κείμενα. Εκτελεί προεπεξεργασία στην είσοδο και μετα-επεξεργασία με βάση το μοντέλο για να δημιουργήσει αναγνώσιμη από τον άνθρωπο έξοδο και ακριβή πρόβλεψη με μέγιστη ακρίβεια.

Αυτό το άρθρο καλύπτει τις ακόλουθες πτυχές:

- Τι είναι η βιβλιοθήκη συνόλων δεδομένων Hugging Face;

- Πώς να εφαρμόσετε Pipelines σε ένα σύνολο δεδομένων σε αγκαλιά με πρόσωπο;

Τι είναι η βιβλιοθήκη συνόλου δεδομένων Hugging Face;

Η βιβλιοθήκη δεδομένων Hugging Face είναι ένα API που περιέχει πολλά δημόσια σύνολα δεδομένων και παρέχει έναν εύκολο τρόπο λήψης τους. Αυτή η βιβλιοθήκη μπορεί να εισαχθεί και να εγκατασταθεί στην εφαρμογή χρησιμοποιώντας το ' κουκούτσι ' εντολή. Για μια πρακτική επίδειξη λήψης και εγκατάστασης συνόλων δεδομένων της βιβλιοθήκης Hugging Face, επισκεφτείτε αυτό Σύνδεσμος Google Colab. Μπορείτε να κάνετε λήψη πολλαπλών συνόλων δεδομένων από το Hugging Face Dataset Hub.

Μάθετε περισσότερα σχετικά με τη λειτουργία της συνάρτησης pipeline() ανατρέχοντας σε αυτό το άρθρο ' Πώς να χρησιμοποιήσετε τη συνάρτηση Pipeline() σε μετασχηματιστές; '.

Πώς να εφαρμόσετε Pipelines σε ένα σύνολο δεδομένων σε αγκαλιά με πρόσωπο;

Το Hugging Face παρέχει πολλά διαφορετικά δημόσια σύνολα δεδομένων που μπορούν εύκολα να εγκατασταθούν χρησιμοποιώντας κώδικα μιας γραμμής. Σε αυτό το άρθρο, θα δούμε μια πρακτική επίδειξη εφαρμογής αγωγών σε αυτά τα σύνολα δεδομένων. Υπάρχουν δύο τρόποι με τους οποίους οι αγωγοί μπορούν να εφαρμοστούν στο σύνολο δεδομένων.

Μέθοδος 1: Χρήση της μεθόδου επανάληψης

Η συνάρτηση pipeline() μπορεί επίσης να επαναληφθεί σε ένα σύνολο δεδομένων και ένα μοντέλο. Για το σκοπό αυτό, ακολουθήστε τα παρακάτω βήματα:

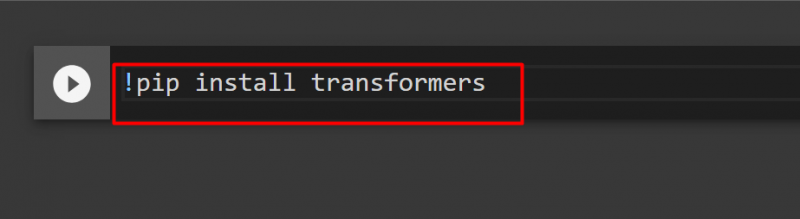

Βήμα 1: Εγκατάσταση Transformer Library

Για να εγκαταστήσετε τη βιβλιοθήκη Transformer, δώστε την ακόλουθη εντολή:

!pip εγκατάσταση μετασχηματιστών

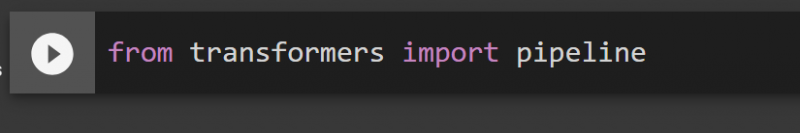

Βήμα 2: Εισαγωγή αγωγών

Μπορούμε να εισαγάγουμε τη διοχέτευση από τη βιβλιοθήκη Transformer. Για το σκοπό αυτό, δώστε την ακόλουθη εντολή:

από αγωγό εισαγωγής μετασχηματιστών

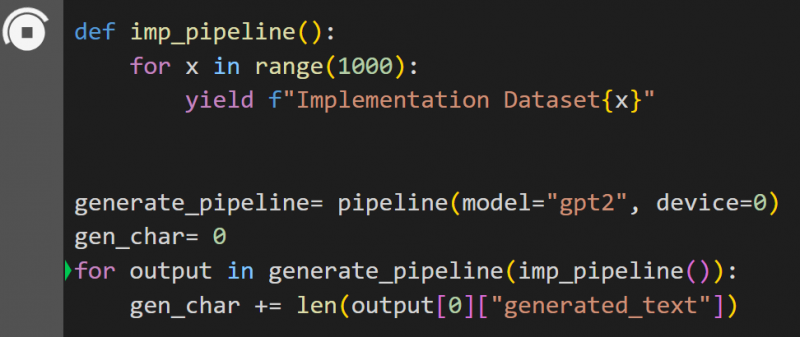

Βήμα 3: Εφαρμογή Pipeline

Εδώ, η συνάρτηση pipeline() υλοποιείται στο μοντέλο ' gpt2 '. Μπορείτε να κατεβάσετε μοντέλα από το Hub Model Hugging Face:

def imp_pipeline():για x στην περιοχή (1000):

απόδοση f'Σύνολο δεδομένων υλοποίησης{x}'

generate_pipeline= pipeline(model='gpt2', συσκευή=0)

gen_char= 0

για έξοδο στο generate_pipeline(imp_pipeline()):

gen_char += len(έξοδος[0]['δημιουργημένο_κείμενο'])

Σε αυτόν τον κώδικα, το « generate_pipeline ' είναι μια μεταβλητή που περιέχει τη συνάρτηση pipeline() με μοντέλο ' gpt2 '. Όταν καλείται με το « imp_pipeline() », αναγνωρίζει αυτόματα τα δεδομένα που αυξάνονται με το εύρος που καθορίζεται στο 1000:

Αυτό θα πάρει λίγο χρόνο για να προπονηθεί. Ο σύνδεσμος προς το Google Co δίνεται επίσης.

Μέθοδος 2: Χρήση της Βιβλιοθήκης συνόλων δεδομένων

Σε αυτή τη μέθοδο, θα δείξουμε την υλοποίηση του αγωγού χρησιμοποιώντας τη βιβλιοθήκη 'συνόλων δεδομένων':

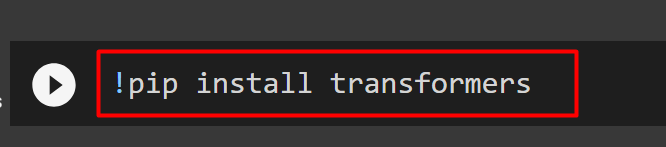

Βήμα 1: Εγκαταστήστε το Transformer

Για να εγκαταστήσετε τη βιβλιοθήκη Transformer, δώστε την ακόλουθη εντολή:

!pip εγκατάσταση μετασχηματιστών

Βήμα 2: Εγκαταστήστε τη βιβλιοθήκη συνόλου δεδομένων

Καθώς το « σύνολα δεδομένων Η βιβλιοθήκη περιέχει όλα τα δημόσια σύνολα δεδομένων, μπορούμε να την εγκαταστήσουμε χρησιμοποιώντας την παρακάτω εντολή. Με την εγκατάσταση του « σύνολα δεδομένων ” βιβλιοθήκη, μπορούμε να εισαγάγουμε απευθείας οποιοδήποτε σύνολο δεδομένων παρέχοντας το όνομά του:

!pip install σύνολα δεδομένων

Βήμα 3: Σωλήνας συνόλου δεδομένων

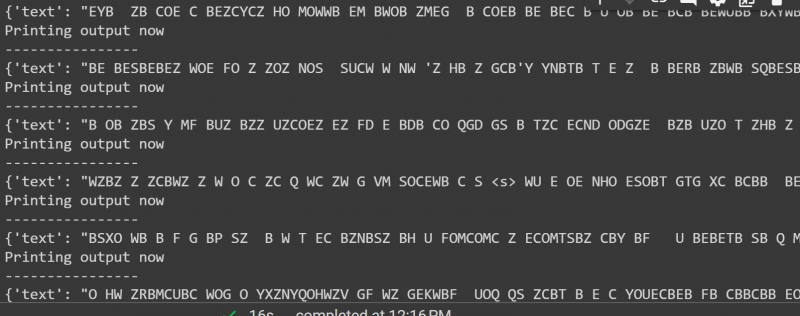

Για να δημιουργήσετε μια διοχέτευση στο σύνολο δεδομένων, χρησιμοποιήστε τον ακόλουθο κώδικα. Το KeyDataset είναι μια δυνατότητα που εξάγει μόνο εκείνες τις τιμές που ενδιαφέρουν τον χρήστη:

από το transformers.pipelines.pt_utils εισαγωγή KeyDatasetαπό αγωγό εισαγωγής μετασχηματιστών

από σύνολα δεδομένων εισαγωγής load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', συσκευή=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')για έξοδο στο gen_pipeline(KeyDataset(loaddataset, 'audio')):

print ('Εκτύπωση τώρα')

Τυπώνω ('----------------')

εκτύπωση (έξοδος)

Η έξοδος του παραπάνω κώδικα δίνεται παρακάτω:

Αυτό είναι όλο από αυτόν τον οδηγό. Ο σύνδεσμος προς το Google Co αναφέρεται επίσης σε αυτό το άρθρο

συμπέρασμα

Για να εφαρμόσουμε αγωγούς στο σύνολο δεδομένων, μπορούμε είτε να κάνουμε επανάληψη σε ένα σύνολο δεδομένων χρησιμοποιώντας μια συνάρτηση pipeline() είτε να χρησιμοποιήσουμε το ' σύνολα δεδομένων ' βιβλιοθήκη. Το Hugging Face παρέχει το σύνδεσμο αποθετηρίου GitHub στους χρήστες του τόσο για σύνολα δεδομένων όσο και για μοντέλα που μπορούν να χρησιμοποιηθούν με βάση τις απαιτήσεις. Αυτό το άρθρο παρέχει έναν περιεκτικό οδηγό για την εφαρμογή αγωγών σε ένα σύνολο δεδομένων στο Transformers.